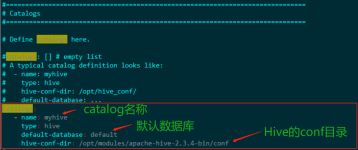

关键点: Flink与Hive结合使用,使用的是Flink引擎作为查询引擎 可以使用Flink的STREAMING 模式从 Hive 读取数据,作为一个解耦写入hive的查询方式 使用 HiveCatalog,Apache Flink 可用于 Apache Hive Tables...

”flink hive“ 的搜索结果

FlinkHive.py

标签: flink

flink 连接hive

flink集成hive 启动:flink-sql 报错: ./sql-client.sh embedded 报错如下: Exception in thread "main" org.apache.flink.table.client.SqlClientException: Unexpected exception. This is a bug....

由于jar包的下载速度很慢,我想也有很多下载慢的同学,分享下

package com.coder.flink.core.aaa_spark; import com.alibaba.fastjson.JSONObject... import com.coder.flink.core.FlinkHive.WriteToHbase_test; import org.apache.commons.lang.StringUtils; import org.apach...

Flink Hive参考文档描述过程总结话不多说,干货`pom文件,不一定是最准确的,但是是能用的。欢迎各位大佬指正。``scala code``Scala stream code` 参考文档 ...描述 过程总结 整个探索的过程,可以总结为‘痛并快乐着...

flink sql flink 整合 hive

一、业务背景 业务需求:需要实时统计截止到目前 存量订购用户数 根据指标口径:截止到目前依旧处于订购状态的用户 分析:根据离线计算统计出来的,目前存量用户有2E多,而要实时统计该指标,需要将新的订购日志与这...

数仓Hive中的数据需要读取后写入Kafka中进行数据服务输出。

错误: 无法初始化主类 bases.DataSteamAPIExample 原因: java.lang.NoClassDefFoundError: org/apache/flink/api/common/functions/FilterFunction

推荐文章

- confluence搭建部署_ata confluence-程序员宅基地

- SpringCloud与SpringBoot版本对应关系_springboot 2.1.1 对于的cloud-程序员宅基地

- 如何恢复硬盘数据?简单解决问题_磁盘恢复 csdn-程序员宅基地

- 苹果手机测试网络速度的软件,App Store 上的“网速测试大师-测网速首选”-程序员宅基地

- 教了一年少儿编程,说说感想和体验-程序员宅基地

- 22东华大学计算机专硕854考研上岸实录-程序员宅基地

- 如何用《玉树芝兰》入门数据科学?-程序员宅基地

- macOS使用brew包管理器_brew清理缓存-程序员宅基地

- 【echarts没有刷新】用按钮切换echarts图表的时候,该消失的图表还在,加个key属性就解决了_echarts 怎么加key值-程序员宅基地

- 常用机器学习的模型和算法_常见机器学习模型算法整理和对应超参数表格整理-程序员宅基地